クルマで知らない場所に行く際、ナビを使うのは当たり前になりました。知らない街で食事する際、スマホでチェックするのも今ではある意味基本動作です。ただ、意外とその二つの動作は連携してないことも多いはず。同乗者がいるときは「オヒルどこで食べるか、ちょっとチェックして」とお願いできますが、一人で運転しているとなかなかそうはいきませんね。

道案内もレストランの検索も、「バーチャルな同乗者」がやってくれる ― そんな未来がやってくるかもしれません。

日産は今年初めに「見えないものを可視化する」技術、Invisible-to-Visible(I2V)を開発し、米ラスベガスで開催された家電見本市CES 2019で発表しました。

I2Vは、いわゆる「コネクテッドカー(つながるクルマ)」の未来を提案する技術で、大きく分けて2つの機能があります。一つは、クルマが周囲をセンシングしたものをクラウドに蓄積してつくられた「メタバース」という仮想世界を活用し、カーブの先や建物の裏など「見えないものを可視化」することによって自動運転の精度と信頼性を上げ、乗員に安心感をもたらすこと。メタバースというと聞きなれないかもしれませんが、映画「マトリクス」のようなパラレルワールド、または最近のバズワードではデジタルツイン、ミラーワールドというとしっくりくるでしょうか。

「自動で運転するなら可視化する必要ないのでは?」と思うかもしれませんね。I2Vの開発者である日産自動車総合研究所のエキスパートリーダー上田哲郎は「ステータスバーみたいなもの」だと語っています。

アプリや動画など大量のデータをダウンロードする際、PCはバックグラウンドで通信しデータを落としていますが、ユーザーは「あとどのくらいから」と進行状況が気になるところ。そのためにステータスバーが表示されます。

クルマがセンシングしたデータはバイナリ(二進数)で通常は解読できません。つまり、自動運転中に周囲はどのような状況になっているかを乗員が把握するために可視化する訳です。

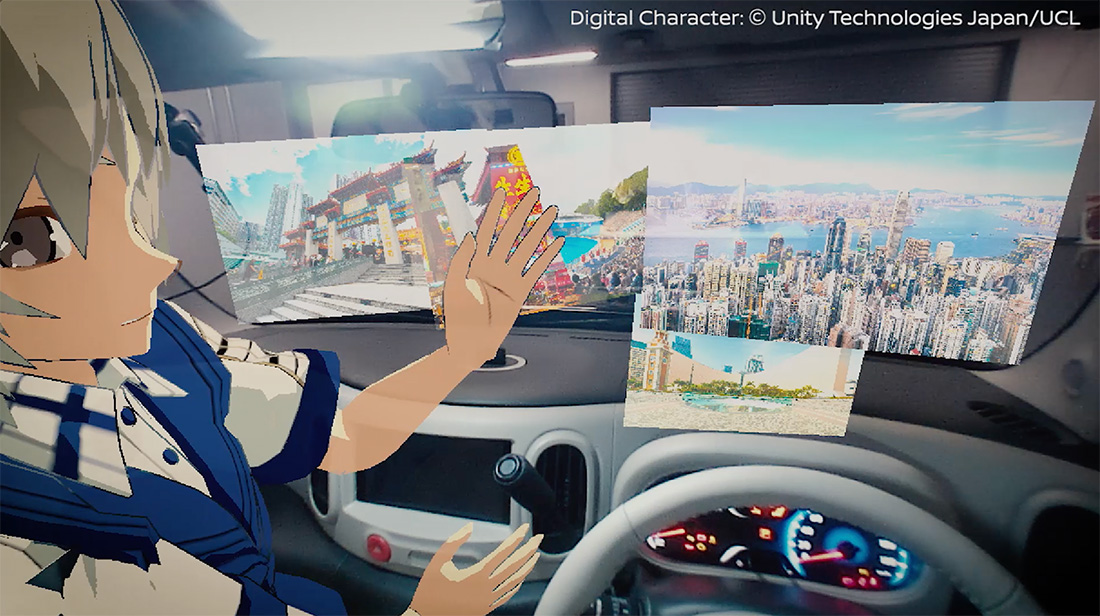

もう一つは、そのメタバースを介して「アバター」と呼ばれるバーチャルの人間が車内に”降臨”する機能です。遠隔地にいる人物が、自動運転中に乗員の話し相手やアシスタントになるというもの。

遠い国に住む友人と会話を楽しむもよし、これから行く街の観光スポットやレストランに詳しいガイドさんでもよし、レーシングドライバーを"召喚"しドラテクを指南してもらうもよし…。

「運転席とか助手席とか、そういった概念を壊したい」と上田は言います。

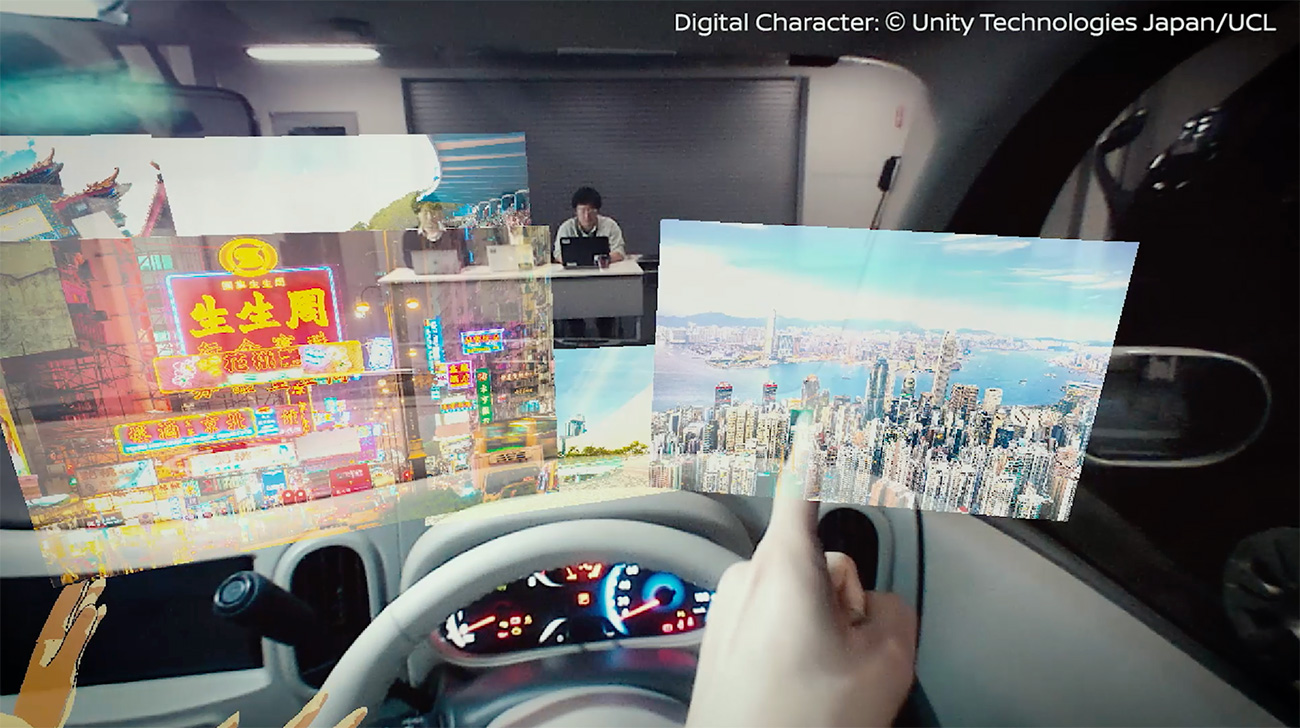

今春、I2Vのシステムを実際の車両に搭載し、離れた場所にいる人物をアバターとして車内に"召喚"する実験が実施されました。

まだ開発途上ではありますが、ARゴーグルを装着した乗員とアバターとの間で身振り手振りを交えた会話だけでなく、握手をしたりバーチャルのお菓子を渡されたりといった"交流"実現しています。

乗員と遅延なくアバターとコミュニケーションするための通信はNTTドコモが2020年にサービスインを目指している超高速大容量の5G回線を使用しました。

実は日産がこのようなコネクテッドカーの開発を始めたのはここ数年のことではありません。振り返ってみると2001年東京モーターショーに出展したコンセプトカー「IDEO(イデオ)」には、クルマの周囲のお勧めスポットや開催中のイベントなどを移動中リアルタイムに表示しサジェストする「シティブラウジング」という機能を既に提案していました。

このIDEOで提案された車両上空から見下ろしたような画面で運転を支援する「アラウンドビューモニター」は2007年に市販化されています。

また2007年のコンセプトカー「PIVO2(ピボ2)」のダッシュボードには「ロボティックエージェント」というAIのアシスタントが埋め込まれており、道案内やお勧めスポット検索、メール読み上げなどサービスをドライバーとの会話によって実現するデバイスが提案されていました。

ちなみに、このロボティックエージェントの目はドライバーの集中力や疲労度合いをモニターする役割も想定していましたが、運転支援中にドライバーが前方を注視しているかをモニターする機能は「プロパイロット 2.0」を搭載する新型スカイラインで実用化される予定です。

6月には上海でCES Asia 2019が初開催となりました。日産はI2Vに加え、デトロイトモーターショーで披露したコンセプトカー「IMs」、および昨年のCESで発表した脳波測定による運転支援技術「Brain-to-Vehicle(B2V)」も積極的に出展。モーターショーだけでなく、ITやエレクトロニクスの世界にも自動車技術が広がっています。